Получение примеров для обучающей и тестовой выборки является серьезной проблемой построения нейросетевых моделей. В большинстве случаев моделируемый объект неизвестен и требуется выполнение экспериментов для нахождения таких примеров.

Если есть возможность экспериментатору задавать значения входных переменных объекта, то возникает задача выбора этих значений, то есть точек, в которых измеряется выходная переменная. При этом обучающая выборка должна быть представительной, охватывать различные сочетания значений входных переменных, а сами значения должны равномерно распределяться в своих диапазонах. Обучающие примеры должны правильно характеризовать функцию ![]() , которая, вообще говоря, неизвестна или о которой имеется лишь общее представление.

, которая, вообще говоря, неизвестна или о которой имеется лишь общее представление.

Необходимо заметить, что вся информация об объекте, который моделируется нейронной сетью, содержится в наборе примеров. Поэтому качество построенной нейросетевой модели непосредственно зависит от того, насколько полно эти примеры описывают объект.

На сегодняшний день не существует строгих рекомендаций по поводу размерности обучающей выборки. Приводятся примерные на оценки количества обучающих пар L обучающей выборки, например [3], ![]() , где W — количество настраиваемых параметров сети (количество весов), ε — погрешность обучения. В [1] число обучающих пар для многослойных сетей прямого распространения с одним скрытым слоем приблизительно оценивается в зависимости от параметров сети как

, где W — количество настраиваемых параметров сети (количество весов), ε — погрешность обучения. В [1] число обучающих пар для многослойных сетей прямого распространения с одним скрытым слоем приблизительно оценивается в зависимости от параметров сети как ![]() , где n, p, m ‒ число нейронов в слоях – во входном, в скрытом и в выходном соответственно.

, где n, p, m ‒ число нейронов в слоях – во входном, в скрытом и в выходном соответственно.

Размерность обучающей выборки определяется различными факторами и не должна быть избыточной. И главным ограничением здесь может являться сложность и высокая стоимость самих экспериментов. Недопустимо становится выполнение опытов в произвольно выбранных точках и в произвольном порядке. Ценность измерений может оказаться невысокой при значительных затратах на их проведение.

Поэтому предлагается использовать принципы теории планирования эксперимента для получения эффективных пар вход-выход как для обучающей, так и для тестовой выборки. Прежде всего, это следующие принципы [2]:

- Принцип последовательного эксперимента – размеры обучающей и тестовой выборок постепенно увеличиваются до тех пор, пока не будет достигнуто обучение заданного качества. Это позволит в случае неудачного обучения доработать обучающую выборку, а не создавать ее заново.

- Нормализация факторов, то есть преобразование натуральных значений факторов в безразмерные. Разные факторы имеют различную размерность и диапазоны изменения значений. Числовые значения этих факторов могут существенно различаться. Факторы с большими числовыми значениями могут в большей мере влиять на выходы и «забивать» остальные [3]. Это особенно заметно, когда нейроны сети имеют одинаковые функции активации. Использование безразмерных значений факторов при обучении уменьшает возможность появления «паралича» сети и приводит к более высокой скорости обучения.

- Точки проведения опытов определяются в соответствии с полными и дробными факторными экспериментами ПФЭ

и ДФЭ

и ДФЭ  . Это позволяет избежать необходимости проведения избыточного количества опытов при большом числе факторов (7 и более) и гарантирует, что не будет пропущено ни одного возможного сочетания факторов и не будет повторения одинаковых опытов. А в случае недостаточности примеров полного факторного эксперимента

. Это позволяет избежать необходимости проведения избыточного количества опытов при большом числе факторов (7 и более) и гарантирует, что не будет пропущено ни одного возможного сочетания факторов и не будет повторения одинаковых опытов. А в случае недостаточности примеров полного факторного эксперимента  можно переходить на тот же план, но с другими диапазонами варьирования факторов.

можно переходить на тот же план, но с другими диапазонами варьирования факторов.

Для нейронной сети выбранной структуры и размерности сначала необходимо примерно оценить размер обучающей выборки (и, следовательно, количество необходимых опытов). Это позволит определить коэффициент дробности k плана ДФЭ ![]() . При числе факторов 2, 3 или 4 это может быть и план ПФЭ

. При числе факторов 2, 3 или 4 это может быть и план ПФЭ ![]() , то есть k — 0. Но при большом числе факторов и, особенно, при сложности проведения опытов дробность может составлять 2…3 и выше.

, то есть k — 0. Но при большом числе факторов и, особенно, при сложности проведения опытов дробность может составлять 2…3 и выше.

Для ДФЭ ![]() определяются основные и дополнительные факторы; задаются значения основных факторов, а значения дополнительных факторов рассчитываются по генерирующим соотношениям [2]. Составляется расширенная матрица плана, которая реализуется, то есть выполняются опыты и находится

определяются основные и дополнительные факторы; задаются значения основных факторов, а значения дополнительных факторов рассчитываются по генерирующим соотношениям [2]. Составляется расширенная матрица плана, которая реализуется, то есть выполняются опыты и находится ![]() примеров обучающей выборки.

примеров обучающей выборки.

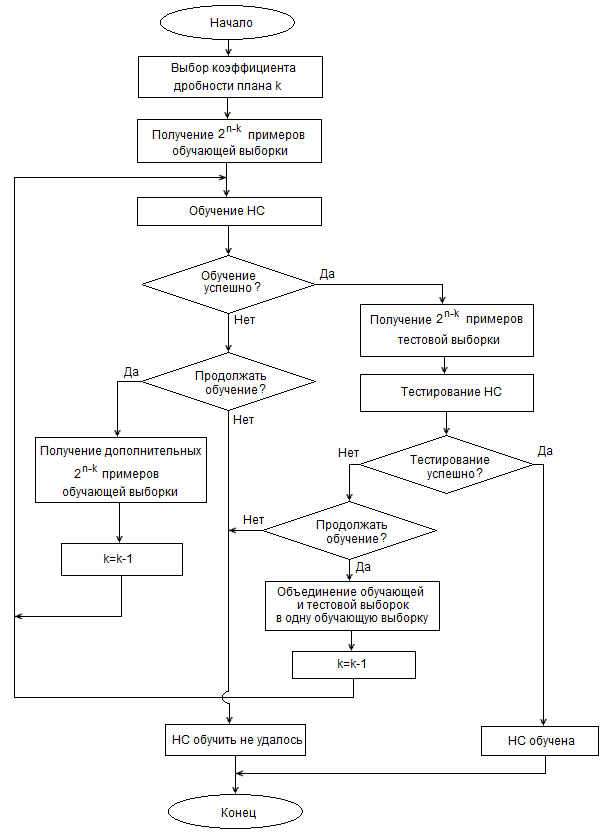

Полученные примеры используются для обучения нейронной сети. По результатам обучения определяются дальнейшие действия.

- Заданная величина ошибки не достигается и сеть обучить не удается.

В этом случае план ДФЭ ![]() достраивается до плана ДФЭ

достраивается до плана ДФЭ ![]() , то есть дробность плана уменьшается на единицу. Генерирующие соотношения для дополнительных факторов инвертируются, и определяется еще

, то есть дробность плана уменьшается на единицу. Генерирующие соотношения для дополнительных факторов инвертируются, и определяется еще ![]() точек плана. В результате матрица плана удваивается, дополнительно производится

точек плана. В результате матрица плана удваивается, дополнительно производится ![]() измерений, обучающая выборка пополняется еще

измерений, обучающая выборка пополняется еще ![]() примерами. Обучение продолжается, но с обучающей выборкой удвоенной размерности.

примерами. Обучение продолжается, но с обучающей выборкой удвоенной размерности.

- Обучение завершается успешно.

В случае успешного обучения необходима проверка, то есть тестирование сети, для чего создается тестовая выборка. Примеры тестовой выборки получаются также достраиванием плана ДФЭ ![]() до плана ДФЭ

до плана ДФЭ ![]() . Производится тестирование на примерах полученной тестовой выборки. Если тестирование прошло удачно, то сеть обучена и готова к работе. Если тестирование показало плохие результаты, то примеры обучающей и тестовой выборок объединяются в одну обучающую выборку. Обучение продолжается или повторяется заново с удвоенной выборкой. В зависимости от результатов обучения повторяются и последующие действия.

. Производится тестирование на примерах полученной тестовой выборки. Если тестирование прошло удачно, то сеть обучена и готова к работе. Если тестирование показало плохие результаты, то примеры обучающей и тестовой выборок объединяются в одну обучающую выборку. Обучение продолжается или повторяется заново с удвоенной выборкой. В зависимости от результатов обучения повторяются и последующие действия.

Общий алгоритм последовательного формирования обучающей и тестовой выборок при обучении нейронной сети представлен на рисунке 1.

Рисунок 1. Алгоритм последовательного формирования обучающей и тестовой выборок при обучении нейронной сети

Каждый раз после неудачного обучения или тестирования сети принимается решение о целесообразности продолжения обучения. В случае продолжения обучения осуществляется переход к плану с дробностью на единицу меньшей.

Такое постепенное уменьшение дробности плана приведет рано или поздно к тому, что коэффициент k станет равным нулю, а сам план – планом полного факторного эксперимента ![]() . Дальнейшее уменьшение коэффициента k, а, следовательно, увеличение размера обучающей выборки или получение тестовой выборки становится невозможно в рамках факторных экспериментов с двумя уровнями варьирования факторов.

. Дальнейшее уменьшение коэффициента k, а, следовательно, увеличение размера обучающей выборки или получение тестовой выборки становится невозможно в рамках факторных экспериментов с двумя уровнями варьирования факторов.

В этом случае предлагается простое решение.

Факторный план ![]() следует понимать как расширение плана ПФЭ

следует понимать как расширение плана ПФЭ ![]() за счет нового плана ПФЭ

за счет нового плана ПФЭ ![]() , в котором факторы также варьируются на двух уровнях, но величина этих уровней теперь другая. Вместо уровней -1 и +1 (как раньше) уровни могут быть, например, -0,5 и +0,5 и в дальнейшем, в случае целесообразности, ±0,75, ±0,25. На рисунке 2 показаны возможные уровни варьирования для двух факторов и отмечены точки, в которых выполняются опыты. Цифры, которыми помечены точки, означают порядок выполнения опытов (в соответствии с порядком, который принят в полных факторных экспериментах).

, в котором факторы также варьируются на двух уровнях, но величина этих уровней теперь другая. Вместо уровней -1 и +1 (как раньше) уровни могут быть, например, -0,5 и +0,5 и в дальнейшем, в случае целесообразности, ±0,75, ±0,25. На рисунке 2 показаны возможные уровни варьирования для двух факторов и отмечены точки, в которых выполняются опыты. Цифры, которыми помечены точки, означают порядок выполнения опытов (в соответствии с порядком, который принят в полных факторных экспериментах).

Рисунок 2. Возможные уровни варьирования для двух факторов

Такой подход позволяет экономно проводить эксперимент, в отличии, например, от перехода к планам ![]() , в которых факторы варьируются на трех уровнях. Кроме того, такие планы ПФЭ с двумя уровнями варьирования значений факторов, отличных от ±1, сохраняют свои замечательные свойства – свойства ортогональности и симметричности. Это позволяет легко находить параметры регрессионной модели. Регрессионная модель также может быть получена для сравнения с обученной нейросетевой моделью.

, в которых факторы варьируются на трех уровнях. Кроме того, такие планы ПФЭ с двумя уровнями варьирования значений факторов, отличных от ±1, сохраняют свои замечательные свойства – свойства ортогональности и симметричности. Это позволяет легко находить параметры регрессионной модели. Регрессионная модель также может быть получена для сравнения с обученной нейросетевой моделью.

Экспериментальная проверка показала, что регрессионная модель в виде полинома первого порядка, построенная по результатам ДФЭ с пренебрежением некоторыми взаимодействиями факторов, и даже модель, построенная по результатам ПФЭ с учетом всех возможных сочетаний факторов, в большинстве случаев обладает меньшей точностью, чем нейронная сеть, обученная на том же экспериментальном материале.

Список литературы:

- Борисов В.В., Круглов В.В. Искусственные нейронные сети. Теория и практика. — М.: Горячая линия – Телеком, 2003. — 382 с.: ил.

- Сидняев Н.И. Теория планирования эксперимента и анализ статистических данных: учебное пособие для магистров. — М.: ИД Юрайт, 2012. — 399 с.

- Хайкин, С. Нейронные сети: полный курс, 2-е издание. Пер. с англ. — М.: Издательский дом «Вильямс», 2006. — 1104 с.: ил.[schema type=»book» name=»ФОРМИРОВАНИЕ ПРИМЕРОВ ОБУЧАЮЩЕЙ И ТЕСТОВОЙ ВЫБОРКИ НЕЙРОННОЙ СЕТИ НА ПРИНЦИПАХ ПЛАНИРОВАНИЯ ЭКСПЕРИМЕНТОВ» description=»Получение примеров обучающей и тестовой выборки для нейронной сети во многих случаях связано с необходимостью выполнения сложных и дорогостоящих экспериментов. В статье предлагается совместить процесс нахождения обучающих и тестовых примеров на принципах планирования эксперимента (и проведение соответствующих измерений) с процессом обучения нейронной сети, что позволит получить размерность выборки, достаточную для качественного обучения и снизить затраты на эксперимент. » author=»Никишечкин Анатолий Петрович, Абдерразек Абдесселлем» publisher=»БАСАРАНОВИЧ ЕКАТЕРИНА» pubdate=»2016-12-21″ edition=»euroasian-science.ru_25-26.03.2016_3(24)» ebook=»yes» ]